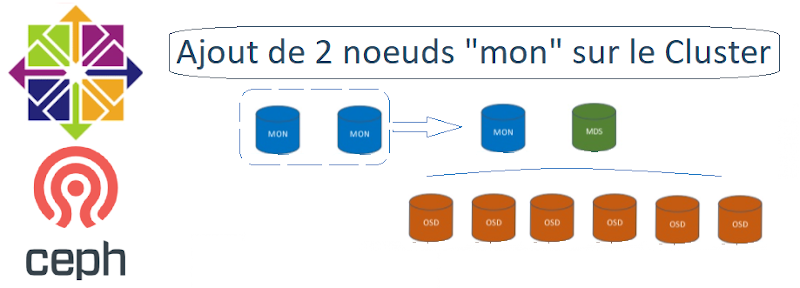

Le but est de rajouter deux autres « moniteur » afin de créer plus de résilience sur le Cluster CEPH.

Actuellement

- node01-ceph-admin

- node02-ceph-mon1

- node03-ceph-osd1

- node04-ceph-osd2

- node05-ceph-osd3

- node06-ceph-osd4

- node07-ceph-osd5

- node08-ceph-osd6

- node09-ceph-osd7

Le but

- node01-ceph-admin

- node02-ceph-mon1

- node03-ceph-osd1

- node04-ceph-osd2

- node05-ceph-osd3

- node06-ceph-osd4

- node07-ceph-osd5

- node08-ceph-osd6

- node09-ceph-osd7

- node10-ceph-mon2

- node11-ceph-mon3

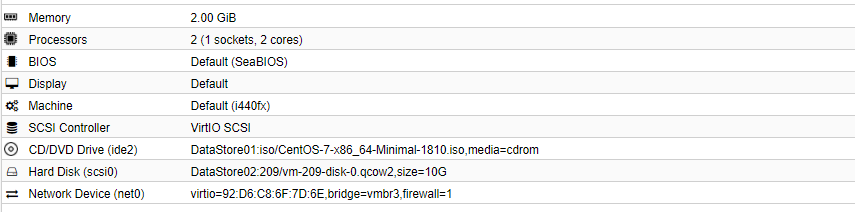

Spécification des nouvelles machines « moniteur »

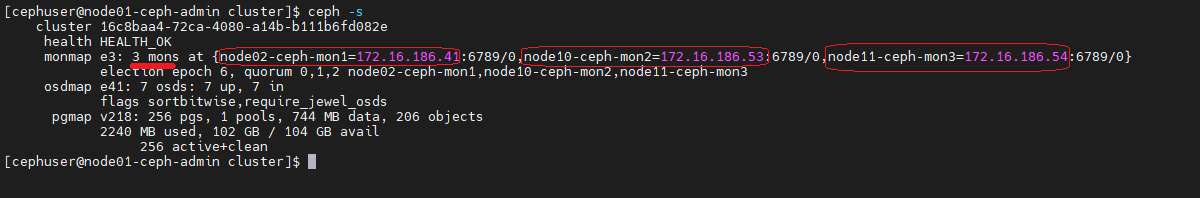

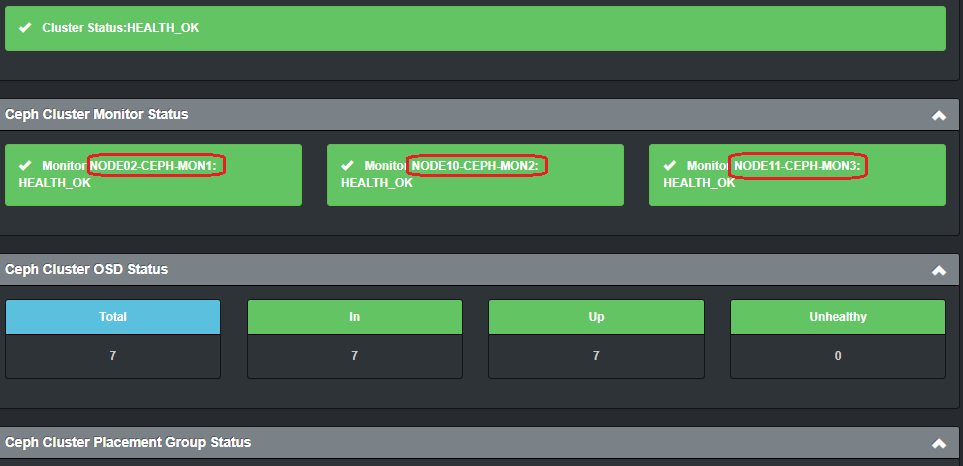

Node10-ceph-mon2

IP : 172.16.186.53

Disque – 1 Système 10Go

RAM 2G

2vCPU

Node11-ceph-mon3

IP : 172.16.186.54

Disque – 1 Système 10Go

RAM 2G

2vCPU

I. Prérequis

1°) ajouter au DNS les nouvelles machines OSD

root@floki03:~# ssh -l root dns-pri.house.cpb

[root@dns-pri ~]# vi /var/named/forward.house.cpb ; Cluster CEPH node01-ceph-admin IN A 172.16.186.40 node02-ceph-mon1 IN A 172.16.186.41 node03-ceph-osd1 IN A 172.16.186.42 node04-ceph-osd2 IN A 172.16.186.43 node05-ceph-osd3 IN A 172.16.186.44 node06-ceph-osd4 IN A 172.16.186.45 node-ceph-client1 IN A 172.16.186.46 node07-ceph-osd5 IN A 172.16.186.47 node08-ceph-osd6 IN A 172.16.186.48 node09-ceph-osd7 IN A 172.16.186.49 node10-ceph-mon2 IN A 172.16.186.53 node11-ceph-mon3 IN A 172.16.186.54

Le reverse

[root@dns-pri ~]# vi /var/named/reversevmbr3.house.cpb ; CEPH CLuster 40 IN PTR node01-ceph-admin.house.cpb. 41 IN PTR node02-ceph-mon1.house.cpb. 42 IN PTR node03-ceph-osd1.house.cpb. 43 IN PTR node04-ceph-osd2.house.cpb. 44 IN PTR node05-ceph-osd3.house.cpb. 45 IN PTR node06-ceph-osd4.house.cpb. 46 IN PTR node-ceph-client1.house.cpb. 47 IN PTR node07-ceph-osd5.house.cpb. 48 IN PTR node08-ceph-osd6.house.cpb. 49 IN PTR node09-ceph-osd7.house.cpb. 53 IN PTR node10-ceph-mon2.house.cpb. 54 IN PTR node11-ceph-mon3.house.cpb.

[root@dns-pri ~]# systemctl reload named

2°) Installation des middlewares (mon2 et mon3)

[root@node10-ceph-mon2 ~]# yum update -y [root@node10-ceph-mon2 ~]# yum install -y htop nmap net-tools wget

3°) Installation ntpd (mon2 et mon3)

[root@node10-ceph-mon2 ~]# yum install ntp ntpdate ntp-doc -y [root@node10-ceph-mon2 ~]# chkconfig ntpd on [root@node10-ceph-mon2 ~]# ntpdate pool.ntp.org [root@node10-ceph-mon2 ~]# systemctl start ntpd

4°) Désactivation Selinux (mon2 et mon3)

[root@node10-ceph-mon2 ~]# sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config [root@node10-ceph-mon2 ~]# reboot

5°) Désactivation IPv6 (mon2 et mon3)

[root@node10-ceph-mon2 ~]# vi /etc/sysctl.conf net.ipv6.conf.all.disable_ipv6 = 1 net.ipv6.conf.all.autoconf = 0 net.ipv6.conf.default.disable_ipv6 = 1 net.ipv6.conf.default.autoconf = 0

[root@node10-ceph-mon2 ~]# sysctl -p

6°) Création Utilisateur et ajout droit sudoers (mon2 et mon3)

[root@node10-ceph-mon2 ~]# useradd -d /home/cephuser -m cephuser [root@node10-ceph-mon2 ~]# passwd cephuser [root@node10-ceph-mon2 ~]# echo "cephuser ALL = (root) NOPASSWD:ALL" >> /etc/sudoers.d/cephuser [root@node10-ceph-mon2 ~]# chmod 0440 /etc/sudoers.d/cephuser [root@node10-ceph-mon2 ~]# sed -i s'/Defaults requiretty/#Defaults requiretty'/g /etc/sudoers

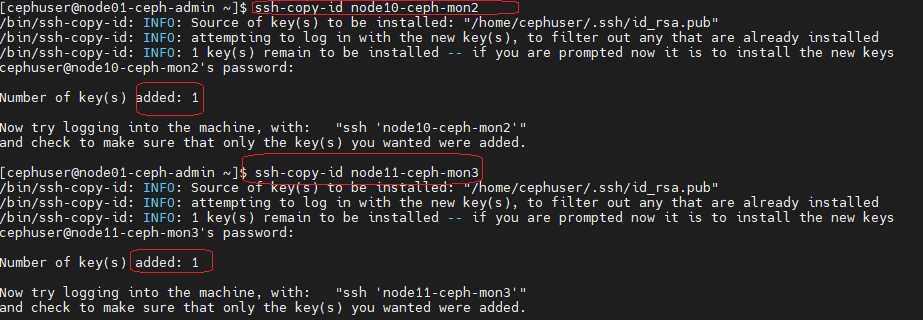

II. Connexion SSH (node01-Ceph-admin)

root@floki03:~# ssh -l root node01-ceph-admin

[cephuser@node01-ceph-admin ~]$ su - cephuser

[cephuser@node01-ceph-admin ~]$ vi ~/.ssh/config Ajouter à la fin du fichier Host node10-ceph-mon2 Hostname node10-ceph-mon2 User cephuser Host node11-ceph-mon3 Hostname node11-ceph-mon3 User cephuser

[cephuser@node01-ceph-admin ~]$ chmod 644 ~/.ssh/config [cephuser@node01-ceph-admin ~]$ ssh-keyscan node10-ceph-mon2 node11-ceph-mon3 >> ~/.ssh/known_hosts

[cephuser@node01-ceph-admin ~]$ ssh-copy-id node10-ceph-mon2 [cephuser@node01-ceph-admin ~]$ ssh-copy-id node11-ceph-mon3

III. Configurer Firewall(mon2 et mon3)

node10-ceph-mon2

[root@node10-ceph-mon2 ~]# systemctl start firewalld && systemctl enable firewalld [root@node10-ceph-mon2 ~]# firewall-cmd --zone=public --add-port=6789/tcp --permanent [root@node10-ceph-mon2 ~]# firewall-cmd --reload [root@node10-ceph-mon2 ~]# firewall-cmd --list-port 6789/tcp

node11-ceph-mon3

[root@node11-ceph-mon3 ~]# systemctl start firewalld && systemctl enable firewalld [root@node11-ceph-mon3 ~]# firewall-cmd --zone=public --add-port=6789/tcp --permanent [root@node11-ceph-mon3 ~]# firewall-cmd --reload [root@node11-ceph-mon3 ~]# firewall-cmd --list-port 6789/tcp

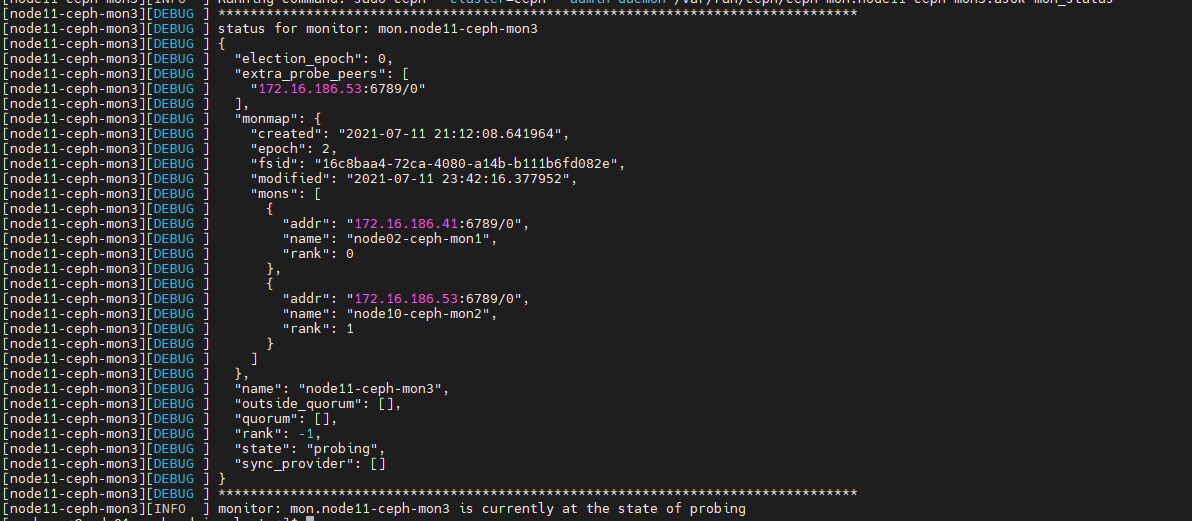

IV. Installer les noeuds mon2 et mon3 (node01-ceph-admin)

1°) Déployer l’installation de CEPH

[cephuser@node01-ceph-admin ~]$ ssh -l root node01-ceph-admin [root@node01-ceph-admin ~]# su - cephuser [cephuser@node01-ceph-admin ~]$ cd cluster/ [cephuser@node01-ceph-admin cluster]$ ceph-deploy install node10-ceph-mon2 node11-ceph-mon3

2°) Ajouter les nœuds mon2 et mon3 au Cluster

[cephuser@node01-ceph-admin cluster]$ ceph-deploy mon add node10-ceph-mon2 --address 172.16.186.53

[cephuser@node01-ceph-admin cluster]$ ceph-deploy mon add node11-ceph-mon3 --address 172.16.186.54

[cephuser@node01-ceph-admin cluster]$ ceph –s

Pour Détruire un Moniteur

[cephuser@node01-ceph-admin cluster]$ ceph-deploy mon destroy node11-ceph-mon3

Views: 12