3 machines GlusterFS

- node01-gfsw 172.16.186.24

- node02-gfsw 172.16.186.25

- node03-gfsw 172.16.186.26

Les trois machines du Cluster auront les mêmes spécifications techniques

1°) Désactivation du SElinux (3 nœuds gfsw)

[root@node01-gfsw ~]# vi /etc/selinux/config SELINUX=disabled

Redémarrer la machine.

[root@ node01-gfsw ~]# reboot

2°) Désactiver l’IPV6 (3 nœuds gfsw)

[root@sftp ~ ]# vi /etc/sysctl.conf net.ipv6.conf.all.disable_ipv6 = 1 net.ipv6.conf.all.autoconf = 0 net.ipv6.conf.default.disable_ipv6 = 1 net.ipv6.conf.default.autoconf = 0

[root@ node01-gfsw ~]# sysctl -p

3°) Installer ntpd (3 nœuds GFS)

[root@node01-gfsw ~]# yum install ntp ntpdate ntp-doc -y [root@node01-gfsw ~]# chkconfig ntpd on [root@node01-gfsw ~]# ntpdate pool.ntp.org [root@node01-gfsw ~]# systemctl start ntpd

4°) Installation GlusterFS (3 nœuds GFS)

[root@node01-gfsw ~]# yum update -y [root@node01-gfsw ~]# yum install -y htop nmap net-tools wget [root@node01-gfsw ~]# yum install -y centos-release-gluster [root@node01-gfsw ~]# yum install -y glusterfs-server [root@node01-gfsw ~]# yum install -y samba

5° ) Installation disque /dev/sdb (3 nœuds GFS)

Tous les fichiers distribués seront stockés sur le disque /dev/sdb.

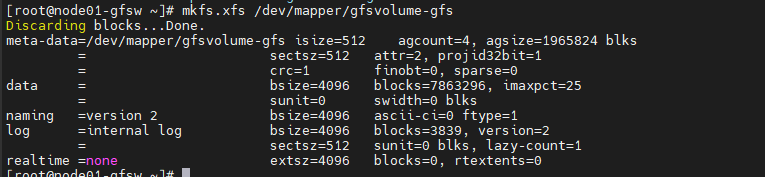

Préparation du disque

[root@node01-gfsw ~]#pvcreate /dev/sdb [root@node01-gfsw ~]# vgcreate gfsvolume /dev/sdb [root@node01-gfsw ~]# lvcreate -n gfs -l 100%FREE gfsvolume [root@node01-gfsw ~]# ls /dev/mapper/ [root@node01-gfsw ~]# mkfs.xfs /dev/mapper/gfsvolume-gfs

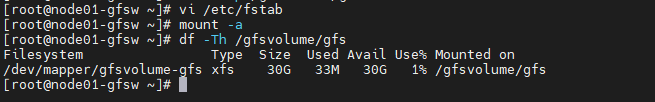

Mount du volume

[root@node01-gfs ~]# mkdir -p /gfsvolume/gfs [root@node01-gfs ~]# vi /etc/fstab #Volume Gluster FS /dev/mapper/gfsvolume-gfs /gfsvolume/gfs xfs defaults 0 0

[root@node01-gfsw ~]# mount -a [root@node01-gfsw ~]# df -Th /gfsvolume/gfs

Démarrer le service

[root@node01-gfsw /]# systemctl enable glusterd.service && systemctl start glusterd.service [root@node01-gfsw /]# systemctl status glusterd.service

6°) Rules Firewall (3 nœuds GFS)

[root@node01-gfs /]# firewall-cmd --zone=public --add-port={24007,24009,2400,111,139,445,965,2049,38465-38469,631,49000-49500}/tcp --permanent [root@node01-gfs /]# firewall-cmd --zone=public --add-port={111,963}/udp --permanent [root@node01-gfs /]# firewall-cmd --reload [root@node01-gfsw ~]# firewall-cmd --list-port 24009/tcp 2400/tcp 111/tcp 139/tcp 445/tcp 965/tcp 2049/tcp 38465-38469/tcp 631/tcp 49000-49500/tcp 111/udp 963/udp

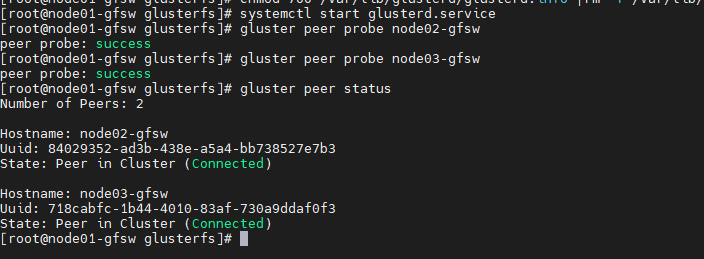

7°) Enrôlement des machines (3 nœuds GFS)

- 172.16.186.24 node01-gfsw (Master)

- 172.16.186.25 node02-gfsw (Slave)

- 172.16.186.26 node03-gfsw (Slave)

[root@node01-gfs ~]# gluster peer probe node02-gfsw [root@node02-gfs ~]# gluster peer probe node03-gfsw [root@node06-gfs ~]# gluster peer status

Petit BUG rencontré et solution si vous le rencontrer

[root@node01-gfsw glusterfs]# systemctl stop glusterd.service [root@node02-gfsw glusterfs]# systemctl stop glusterd.service [root@node03-gfsw glusterfs]# systemctl stop glusterd.service

[root@node01-gfsw glusterfs]# chmod 700 /var/lib/glusterd/glusterd.info | rm -f /var/lib/glusterd/glusterd.info

[root@node01-gfsw glusterfs]# systemctl start glusterd.service [root@node02-gfsw glusterfs]# systemctl start glusterd.service [root@node03-gfsw glusterfs]# systemctl start glusterd.service

[root@node01-gfsw ~]# gluster peer probe node02-gfsw [root@node02-gfsw ~]# gluster peer probe node03-gfsw

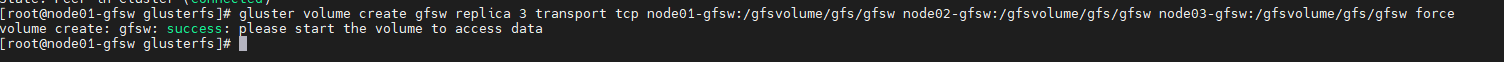

8°) Création et préparation du volume gsfsys (node01-gfsw)

Création du volume sur 3 réplicats

[root@node01-gfs ~]# gluster volume create gfsw replica 3 transport tcp node01-gfsw:/gfsvolume/gfs/gfsw node02-gfsw:/gfsvolume/gfs/gfsw node03-gfsw:/gfsvolume/gfs/gfsw force

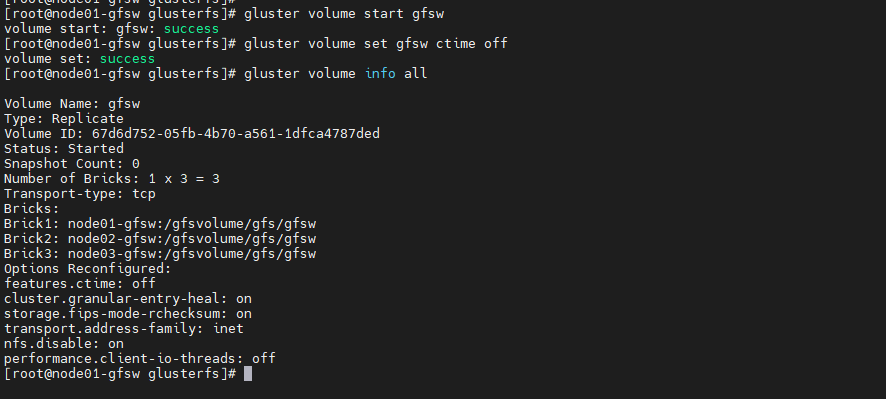

[root@node06-gfs ~]# gluster volume start gfsw [root@node06-gfs ~]# gluster volume set gfsw ctime off [root@node06-gfs ~]# gluster volume info all

Le cluster GlusterFS est désormais Opérationnel.

Views: 14