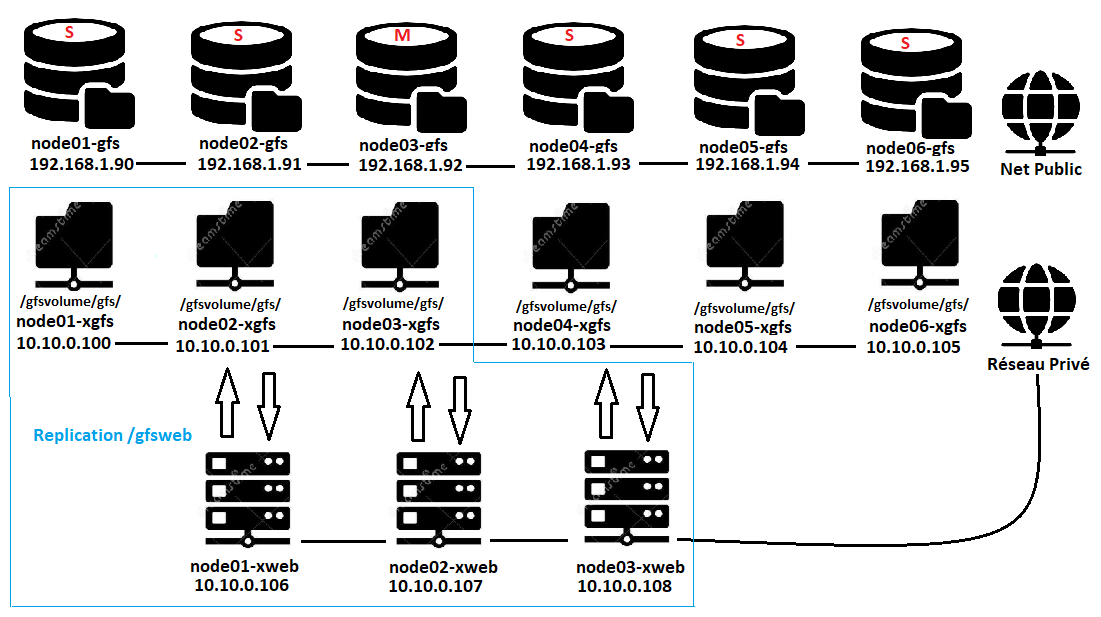

6 Machines GlusterFS Serveur et stockage Distribué sous Centos7

- Node01-gfs : 192.168.1.90 – 10.10.0.100 (Réseau Privé)

- Node02-gfs : 192.168.1.91 – 10.10.0.101 (Réseau Privé)

- Node03-gfs : 192.168.1.92 – 10.10.0.102 (Réseau Privé)

- Node04-gfs : 192.168.1.93 – 10.10.0.103 (Réseau Privé)

- Node05-gfs : 192.168.1.94 – 10.10.0.104 (Réseau Privé)

- Node06-gfs : 192.168.1.95 – 10.10.0.105 (Réseau Privé)

Le Pool « SerFile» va être composé de trois machines virtuelles

- Node01

- node01-gfs -> 192.168.1.90 – Réseau Public

- node01-xgfs -> 10.10.0.100 – Réseau Privé (Fichiers Distribués)

- 2CPU, 1G RAM

- Disque /dev/sda : 10Go (Système Centos7)

- Disque /dev/sdb : 30Go (Fichiers Distribués)

- Node02

- node02-gfs -> 192.168.1.91 – Réseau Public

- node02-xgfs -> 10.10.0.101 – Réseau Privé (Fichiers Distribués)

- 2CPU, 1G RAM

- Disque /dev/sda : 10Go (Système Centos7)

- Disque /dev/sdb : 30Go (Fichiers Distribués)

- Node03

- node03-gfs -> 192.168.1.92 – Réseau Public

- node03-xgfs -> 10.10.0.102 – Réseau Privé (Fichiers Distribués)

- 2CPU, 1G RAM

- Disque /dev/sda : 10Go (Système Centos7)

- Disque /dev/sdb : 30Go (Fichiers Distribués)

- Node04

- node04-gfs -> 192.168.1.93 – Réseau Public

- node04-xgfs -> 10.10.0.103 – Réseau Privé (Fichiers Distribués)

- 2CPU, 1G RAM

- Disque /dev/sda : 10Go (Système Centos7)

- Disque /dev/sdb : 30Go (Fichiers Distribués)

- Node05

- Node05-gfs -> 192.168.1.94 – Réseau Public

- node05-xgfs -> 10.10.0.104 – Réseau Privé (Fichiers Distribués)

- 2CPU, 1G RAM

- Disque /dev/sda : 10Go (Système Centos7)

- Disque /dev/sdb : 30Go (Fichiers Distribués)

- Node06

- node02-gfs -> 192.168.1.95 – Réseau Public

- node02-xgfs -> 10.10.0.105 – Réseau Privé (Fichiers Distribués)

- 2CPU, 1G RAM

- Disque /dev/sda : 10Go (Système Centos7)

- Disque /dev/sdb : 30Go (Fichiers Distribués)

Suppression du selinux (6 nœuds GFS)

[root@node01-gfs ~]# vi /etc/sysconfig/selinux SELINUX=disabled

Redémarrage de la machine.

Installer ntpd (6 nœuds GFS)

[root@node01-gfs ~]# yum install ntp ntpdate ntp-doc -y [root@node01-gfs ~]# chkconfig ntpd on [root@node01-gfs ~]# ntpdate pool.ntp.org [root@node01-gfs ~]# systemctl start ntpd

Désactiver l’IPV6 (6 nœuds GFS)

[root@node01-gfs ]# vi /etc/sysctl.conf # désactivation de ipv6 pour toutes les interfaces net.ipv6.conf.all.disable_ipv6 = 1 # désactivation de l’auto configuration pour toutes les interfaces net.ipv6.conf.all.autoconf = 0 # désactivation de ipv6 pour les nouvelles interfaces (ex:si ajout de carte réseau) net.ipv6.conf.default.disable_ipv6 = 1 # désactivation de l’auto configuration pour les nouvelles interfaces net.ipv6.conf.default.autoconf = 0

[root@node01-gfs]# sysctl -p

Ajouter sur toutes les machines des hosts (6 nœuds GFS) si vous n’avez pas de DNS

[root@node01-gfs ]# vi /etc/hosts #Cluster gfs Reseau Public 192.168.1.90 node01-gfs node01-gfs.house.cpb node01-gfs 192.168.1.91 node02-gfs node02-gfs.house.cpb node02-gfs 192.168.1.92 node03-gfs node03-gfs.house.cpb node03-gfs 192.168.1.93 node04-gfs node04-gfs.house.cpb node04-gfs 192.168.1.94 node05-gfs node05-gfs.house.cpb node05-gfs 192.168.1.95 node06-gfs node06-gfs.house.cpb node05-gfs #Cluster web 192.168.1.96 node01-web node01-web.house.cpb node01-web 192.168.1.97 node02-web node02-web.house.cpb node02-web 192.168.1.98 node03-web node03-web.house.cpb node03-web #### Reseau Prive x #Cluster gfs 10.10.0.100 node01-xgfs node01-xgfs.house.cpb node01-xgfs 10.10.0.101 node02-xgfs node02-xgfs.house.cpb node02-xgfs 10.10.0.102 node03-xgfs node03-xgfs.house.cpb node03-xgfs 10.10.0.103 node04-xgfs node04-xgfs.house.cpb node04-xgfs 10.10.0.104 node05-xgfs node05-xgfs.house.cpb node05-xgfs 10.10.0.105 node06-xgfs node06-xgfs.house.cpb node06-xgfs #Cluster Serveur Web 10.10.0.106 node01-xweb node01-xweb.house.cpb node01-xweb.home 10.10.0.107 node02-xweb node02-xweb.house.cpb node02-xweb.home 10.10.0.108 node03-xweb node03-xweb.house.cpb node03-xweb.home

Installation des paquets des serveurs GlusterFS (6 nœuds GFS)

[root@node01-gfs ~]# yum update -y [root@node01-gfs ~]# yum install htop nmap net-tools wget [root@node01-gfs ~]# yum install -y centos-release-gluster [root@node01-gfs ~]# yum install -y glusterfs-server [root@node01-gfs ~]# yum install -y samba

Préparation du disque /dev/sdb et du point de montage (6 nœuds GFS)

[root@node01-gfs ~]#pvcreate /dev/sdb [root@node01-gfs ~]# vgcreate gfsvolume /dev/sdb [root@node01-gfs ~]# lvcreate -n gfs -l 100%FREE gfsvolume [root@node01-gfs ~]# ls /dev/mapper/

[root@node01-gfs ~]# mkfs.xfs /dev/mapper/gfsvolume-gfs [root@node01-gfs ~]# mkdir -p /gfsvolume/gfs [root@node01-gfs ~]# vi /etc/fstab /dev/mapper/gfsvolume-gfs /gfsvolume/gfs xfs defaults 0 0 [root@node01-gfs ~]# mount -a [root@node01-gfs ~]# df -Th /gfsvolume/gfs Sys. de fichiers Type Taille Utilisé Dispo Uti% Monté sur /dev/mapper/gfsvolume-gfs xfs 10G 33M 10G 1% /gfsvolume/gfs

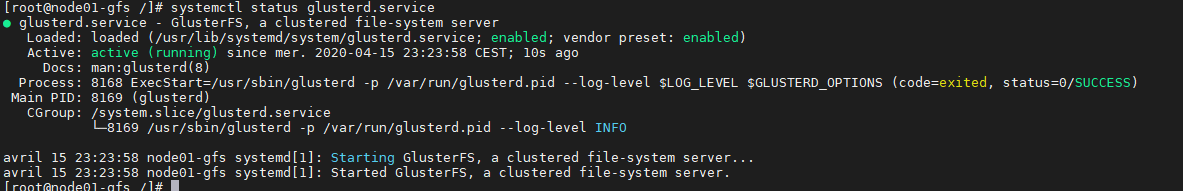

Activer le serveur glusterFS (6 nœuds GFS)

[root@node01-gfs /]# systemctl enable glusterd.service && systemctl start glusterd.service [root@node01-gfs /]# systemctl status glusterd.service

Ajout des Rules dans le Firewall (6 nœuds GFS)

[root@node01-gfs /]# firewall-cmd --zone=public --add-port={24009,2400,111,139,445,965,2049,38465-38469,631,49000-49500}/tcp --permanent [root@node01-gfs /]# firewall-cmd --zone=public --add-port={111,963}/udp --permanent [root@node01-gfs ~]# firewall-cmd --zone=public [root@node01-gfs /]# firewall-cmd --reload

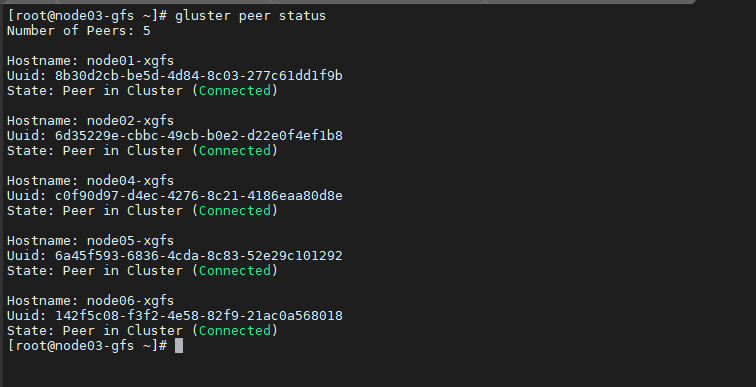

Choix Serveur Maitre et enrôlement des Slaves (node03-gfs)

Le serveur Maître sera le Serveur node06-xgsf. Celui-ci sera le serveur principal qui connectera les serveurs ensembles. Les serveurs seront interconnectés via le réseau privé 10.10.0.0/16.

- 10.10.0.100 node01-xgfs

- 10.10.0.101 node02-xgfs

- 10.10.0.102 node03-xgfs

- 10.10.0.103 node04-xgfs

- 10.10.0.104 node05-xgfs

- 10.10.0.105 node06-xgfs

[root@node06-gfs ~]# gluster peer probe node01-xgfs [root@node06-gfs ~]# gluster peer probe node02-xgfs [root@node06-gfs ~]# gluster peer probe node04-xgfs [root@node06-gfs ~]# gluster peer probe node05-xgfs [root@node06-gfs ~]# gluster peer probe node06-xgfs

Vérifions le statut des nœuds enrôlés.

[root@node06-gfs ~]# gluster peer status

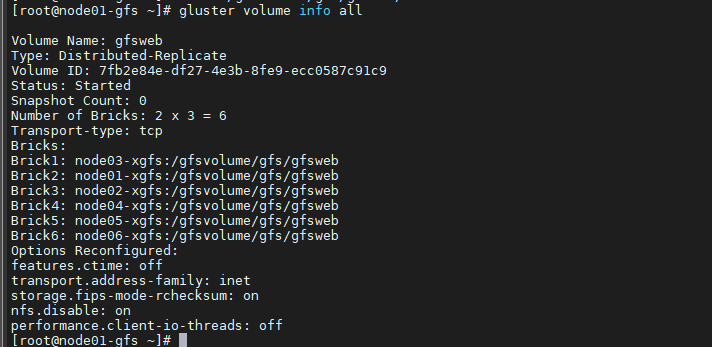

Création et préparation du volume gsfweb (node03-gfs)

Création du volume gfsweb sur 3 réplicats

[root@node06-gfs ~]#gluster volume create gfsweb replica 3 transport tcp node03-xgfs:/gfsvolume/gfs/gfsweb node01-xgfs:/gfsvolume/gfs/gfsweb node02-xgfs:/gfsvolume/gfs/gfsweb node04-xgfs:/gfsvolume/gfs/gfsweb node05-xgfs:/gfsvolume/gfs/gfsweb node06-xgfs:/gfsvolume/gfs/gfsweb force

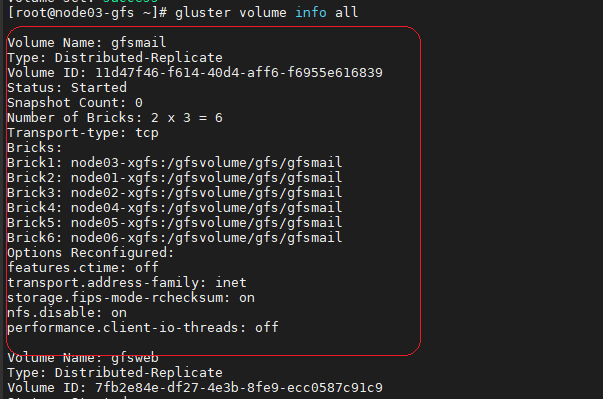

[root@node06-gfs ~]# gluster volume start gfsweb [root@node06-gfs ~]# gluster volume set gfsweb ctime off [root@node06-gfs ~]# gluster volume info all

Création et préparation du volume gsfmail sur 6 réplicats (node03-gfs)

Création du volume gfsmail sur 6 réplicats

[root@node06-gfs ~]#gluster volume create gfsmail replica 6 transport tcp node03-xgfs:/gfsvolume/gfs/gfsmail node01-xgfs:/gfsvolume/gfs/gfsmail node02-xgfs:/gfsvolume/gfs/gfsmail node04-xgfs:/gfsvolume/gfs/gfsmail node05-xgfs:/gfsvolume/gfs/gfsmail node06-xgfs:/gfsvolume/gfs/gfsmail force

[root@node06-gfs ~]# gluster volume start gfsmail [root@node06-gfs ~]# gluster volume set gfsmail ctime off [root@node06-gfs ~]# gluster volume info all

Pour information, supprimer un Volume existant

gluster volume stop gfsmail gluster volume delete gfsmail

Ajout d’un client GluterFS sur le Cluster

- Node01-web : 192.168.96 – 10.10.0.106 (Réseau Privé)

Installation du client Gluterfs

[root@node01-web ~]# yum -y install glusterfs-fuse [root@node01-web ~]# mkdir /gfsweb

Installation ntp

[root@node01-web ~]# yum install ntp ntpdate ntp-doc [root@node01-web ~]# chkconfig ntpd on [root@node01-web ~]# ntpdate pool.ntp.org [root@node01-web ~]# systemctl start ntpd

Montage de la ressource /gfsweb

[root@node01-web ~]# mount -t glusterfs node02-gfs:/gfsweb /gfsweb

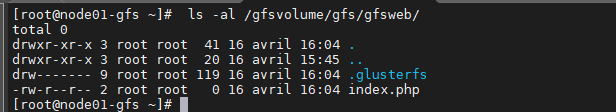

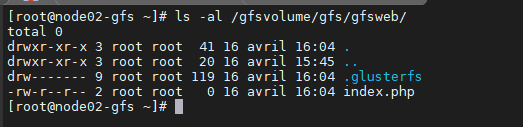

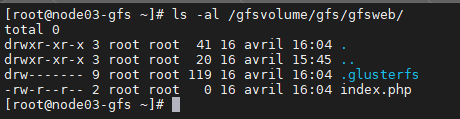

Test à partir du client node01-web

[root@node01-web ~]# touch /gfsweb/index.php

Sur les 3 Serveurs de réplication GlusterFS (node01-gfs,node02-gfs et node03-gfs)

Montage de la ressource /gfsweb dans /etc/fstab

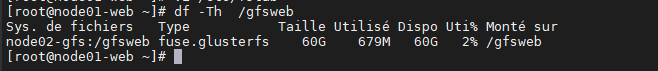

[root@node01-web ~]# vi /etc/fstab node02-gfs:/gfsweb /gfsweb glusterfs defaults,_netdev 0 0 [root@node01-web ~]# mount –a [root@node01-web ~]# df -Th /gfsweb

Views: 24